1.论文概要

研究背景:

✡︎论文链接。Non_local通过聚合全局上下文信息到目标位置来捕获远程依赖性关系。然而文中表明通过实验分析发现聚合后的全局上下文信息对于图像内的不同查询位置几乎相同。Non-local网络中,对于每个查询位置,首先计算查询位置与所有位置的之间的成对关系得到注意力分布图,然后通过加权和与注意图定义的权重来聚合所有位置的特征。但是文中通过可视化某一具体位置的注意力分布图发现,对比三个不同的点,其注意力分布图几乎无异。

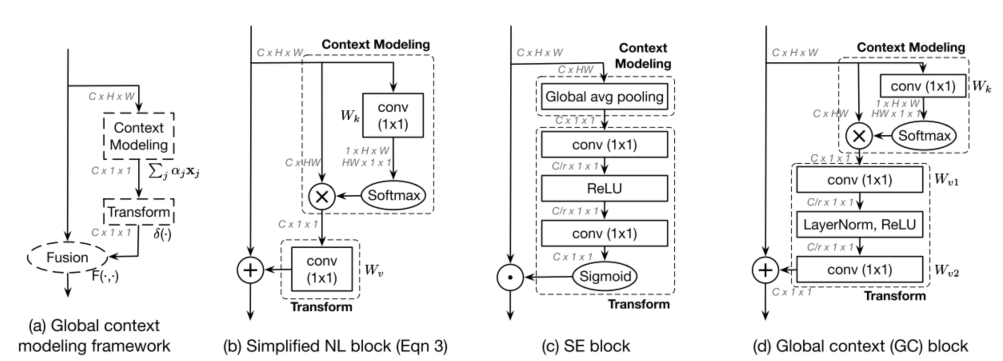

基于此,文中提出基于位置关系独立的查询公式来简化网络,由于其与SE-Net的相似性,文中提出改进后的Non-local与Set-Net的结合网络,网络基础快命名为全局上下文块(GC)

2.算法应用

Simplifying Non-local

通过实验,文中得证对于大多数点各自对应的注意力分布图几乎相同,所以可以认为虽然Non-local聚合了全局上下文信息,但训练得到的全局上下文实际上独立于查询位置。因此,无需为每个位置计算特定的全局上下文,文中提出通过计算全局注意力图来让所有位置点共享此概率分布图。

简化后的non-local块和SE-Net有很多相同之处,例如他们都通过从所有位置汇总相同特征来增强原始特征,但聚合策略、转换和融合增强函数有所不同。文中进一步抽象统一Non-local和SE-Net,得到一个三步架构,1)上下文建模模块,用以聚合全局上下文特征;2)特征转换模块,用以捕获通道间的依赖性;3)融合模块,用以将全局上下文特征合并到所有位置特征中。

Simplifying non-local的块结构如图1(b)

SE的改进

如图1(c)

网络设计

如图1(d)

☛参考文献

[1] D. Han, J. Kim, and J. Kim, “Deep pyramidal residual networks,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit. (CVPR), Jul. 2017,pp. 6307–6315, doi: 10.1109/CVPR.2017.668